Google har tagit fram en egen datorkrets för att driva neurala nätverk, en AI-teknik som kan förändra det sätt internettjänster fungerar på.

I ett uppmärksammat blogginlägg har Google informerat om att företaget har utformat en ASIC, (Application Specific Integrated Circuit), alltså en integrerad krets som har en specifik funktion snarare än en allmän uppgift, särskilt avsedd för neurala nät. Det innebär nätverk av hårdvara och mjukvara som kan lära sig specifika uppgifter genom att analysera stora mängder data.

Neurala nätverk

Ett neuronnät eller neuralt nätverk är en signalflödesmodell för hjärnor och andra nervsystem. Begreppet kan även åsyfta artificiella neuronnät, som är ett samlingsnamn på ett antal självlärande algoritmer för informationsbehandling som försöker efterlikna funktionen i biologiska neuronnät – och här har Google satsat på egen teknik för artificiell intelligens.

Google använder neurala nät för att identifiera objekt och ansikten i foton, känna igen talade kommandon till Android-telefoner och för att översätta text från ett språk till ett annat. Tekniken är också på väg att omvandla Googles sökmotor.

Tensor Processing Unit

Google kallar sin krets Tensor Processing Unit, eller TPU, eftersom den förstärker Tensorflow, programvaran som driver deras inlärningstjänster. I höstas släppte Google Tensorflow under en öppen källkod-licens, vilket innebär att vem som helst utanför företaget kan använda och ändra mjukvaran. Google har inte sagt något om att man har för avsikt att dela konstruktionen av sin TPU, men utomstående kan utnyttja Googles hårdvara och mjukvara för maskininlärning via olika av deras molntjänster.

Google är bara ett av många företag som utnyttjar djupinlärning i ett brett utbud av internettjänster. Facebook, Microsoft och Twitter deltar också i den internetförändring som drivs av artificiell intelligens. Hittills har Internetjättarna kört sina neurala nät med hjälp av grafikprocessorer (GPU) eller kretsar kallade FPGA (Field-Programmable Gate Array), men nu vill alltså Google få bättre funktion med dedikerade kretsar.

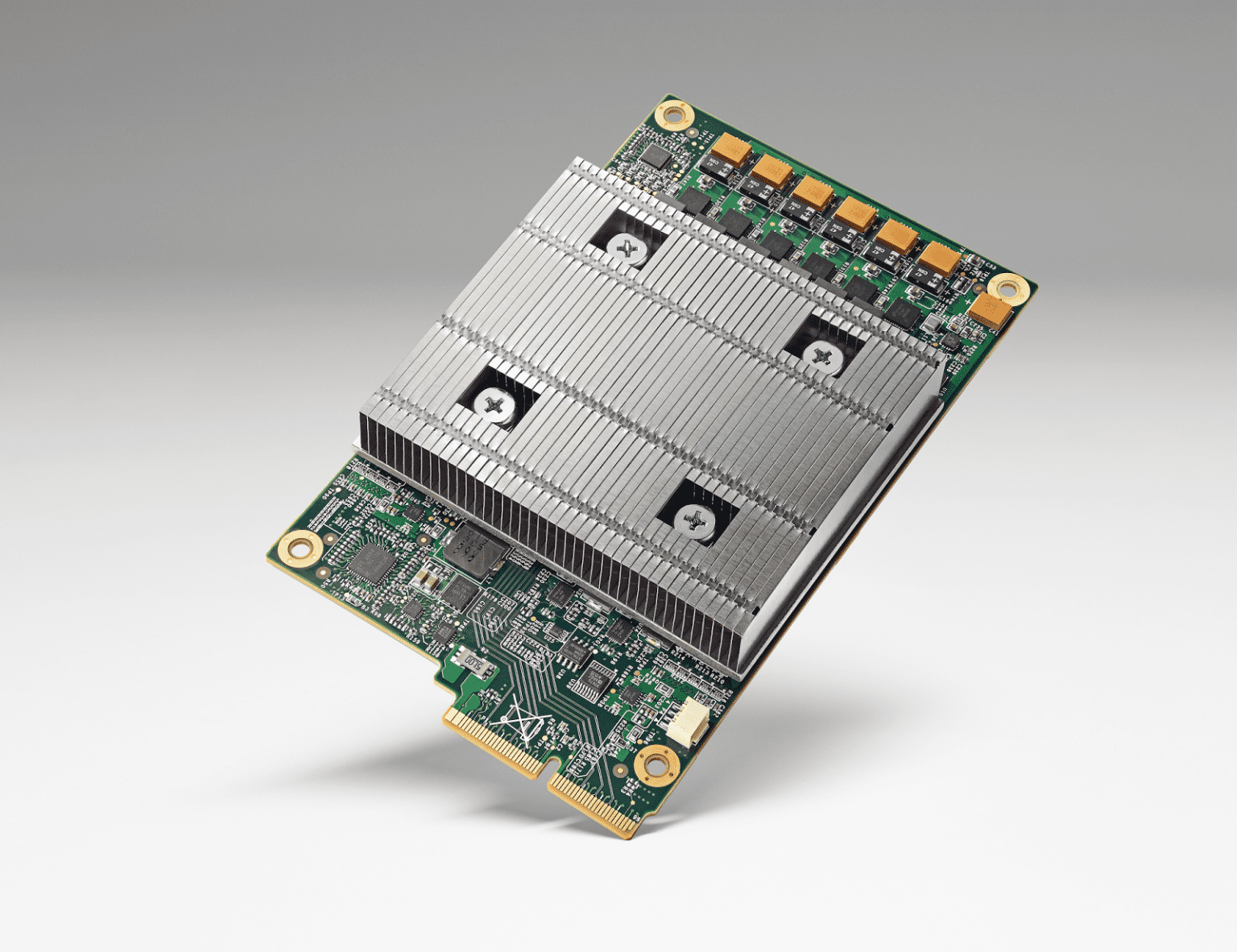

Kort med PCIe

Google säger att de har använt TPU:er i ungefär ett år, och att de utvecklades inte långt innan dess. De kompakta TPU-korten passar i samma PCI Express-uttag som en hårddisk i de massiva hårdvaruracken i Googles datacenter. Enligt företaget ger deras egna kretsar bättre och mer optimerad prestanda för maskininlärning per watt än andra hårdvarualternativ.

– TPU:n är anpassad till maskininlärningsapplikationer, vilket gör att kretsen kan vara mer tolerant mot minskad beräkningsprecision, vilket innebär att det krävs färre transistorer per operation, säger Google i sitt blogginlägg. Tack vare detta kan vi pressa in fler operationer per sekund i kislet, använda mer sofistikerade och kraftfulla maskininlärningsmodeller och tillämpa dessa modeller snabbare, så att användarna får mer intelligenta resultat kvickare, fortsätter man.

Att Google nu tillverkar sina egna kretsar innebär förstås att man kommer att använde mindre traditionell teknik i framtiden. Företaget har dock inte avslöjat var deras TPU:er tillverkas. Inte heller har man berättat särskilt mycket om dem, mer än att de stora kylflänsarna bland annat döljer minnesbestyckningen.

Enligt Google är deras mål att leda utvecklingen när det gäller maskininlärning och göra uppfinningsresultaten tillgängliga för sina kunder.