AMD accelererar AI utnyttjande med hjälp av nya Ryzen AI och AMD Ryzen AI Software

AMD trappar upp satsningen på AI rent generellt och lösningar som fokuserar på generativ AI både i form av hårdvara och mjukvara. Bara knappa sex månader efter att AMD höll sitt AI fokuserade DataCenter event i San Francisco den 13 juni 2023 så togs nästa steg då AMD, denna gång i San Jose, under den sjätte december presenterade såväl nya processorer med fokus på AI samt nya programlösningar vilket bland annat omfattade ROCm6 som enkel uttrycket är en mjukvarustack för programmering av grafikprocessorer som nya Instinct MI300A APU för AI datorer och MI300X GPU för HPC. Datormagazin på plats och fick en nära inblick i vad som kan komma att bli en mycket intressant kamp mot framför allt Nvidia på GPU sidan och Intel på CPU sidan.

AMD Ryzen AI

Som AMD visade upp redan i San Francisco så erbjuder företaget den enda kompletta portföljen av AI optimerade lösningar inom dataindustrin. Detta omfattar allt från Datacenters via traditionella datorer och Edge-enheter till alla former av endpointlösningar där vi bland annat sett AMDs Instinct och Alevo acceleratorer samt olika lösningar baserade på AMDs integrerade Versal chip och de mobila Ryzen 7040 processorerna.

Under eventet i San Jose så lyftes nu nästa steg och det i form av den mer personliga AI lösningen som vi kommer att se i delvis redan lanserade, men fram för allt kommande modeller. AMD lyfte här sin NPU lösning, XDNA, som är en dedikerad AI motor för användare som behöver mobil AI bearbetning när de är på språng.

Denna kompletteras dels med Zen baserade CPUer med högfrekventa kärnor som använder AVX-512 VNNI instruktioner för att accelerera AI bearbetning, dels RDNA baserade AMD Radeon GPUer för parallell databearbetning av AI belastningar. För att dessa delar ska slå fullt ut så lyfter AMD fyra punkter som lösningarna måste uppfylla och dessa är: prestanda, säkerhetsfunktioner, kostnad samt effektivitet. Till detta så arbetar AMD sedan efter en tvåstegs policy för att få ut produkterna på marknaden.

- Se till att hårdvaran finns tillgänglig: Med lanseringen av Ryzen 7040 serien och Ryzen AI under 2023 introducerades världens första dedikerade AI motor för en X86 processor. Med mer än 50 olika Ryzen AI baserade system tillgängliga på marknaden har det funnits lösningar för såväl konsumenter att använda som utvecklare för testning. Detta har lett till att flera miljoner Ryzen AI processorer redan har sålts och används.

- Breda utvecklarmöjligheter: AMD arbetar fortlöpande med de större utvecklar aktörerna för att säkerställa att en industristandardiserad programvara är tillgänglig, stödd och optimerad. Till detta så tillhandahåller AMD ett brett utbud av verktyg som gör det möjligt för utvecklare att snabbt och enkelt bygga och applicera AI program. Detta har bland annat resulterar i att vi redan i skrivandes stund hittar mer än hundra AI optimerade och drivna lösningar inom bland annat Photoshop, Premiere, Lightroom och Black Magics DaVinci Resolve

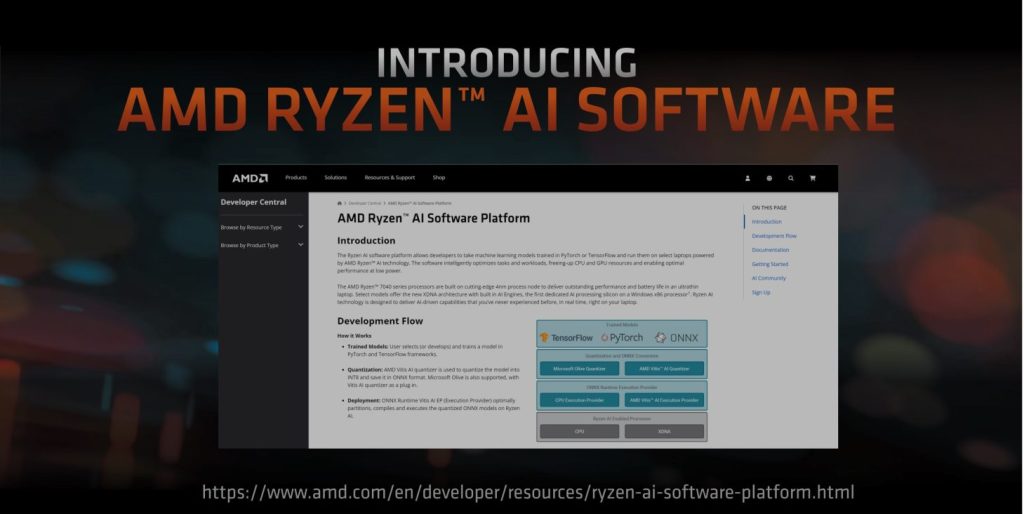

Ryzen AI programplattform

För att ta allt till nästa nivå både sett till möjligheter och optimering så presenterade AMD under eventet en öppen källkodbaserad lösning för skapande och användande av AI motorer i Windows i form av ONNX Runtime och AMD Ryzen AI utvecklarprogramvara.

Programmet som finns att hämta hem här, gör det möjligt för utvecklare att starta med en AI modell från något av industrins standardformat som PyTorch, TensorFlow eller ONNX och sedan använda AMDs program för att anpassa och sedan distribuera med ONNX Runtime och på detta sätt göra programmet redo att användas med AMD Ryzen AI baserade system.

Detta gör det möjligt för utvecklare att snabbt skapa och distribuera modeller för generativ AI på AMD Ryzen AI datorer med fokus på högre prestanda när XDNA hårdvara används i botten. Samtidigt så gör det breda stödet för olika AI modeller och den bredd av steg för steg genomgångar som finns för utvecklare det möjligt att snabbt komma igång även om all kunskap inte finns från start.

För att öka på användningen av AMDs hårdvara och program så har AMD även, tillsammans med Hackster.io tagit fram tre tävlingar inom generativ AI, Robotics AI och PC AI.

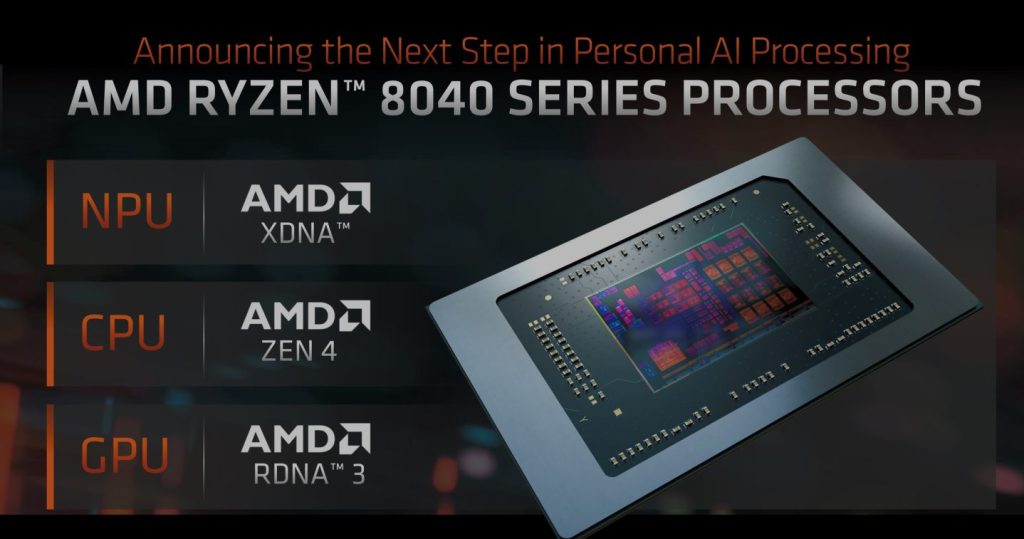

Nästa generations AI processorer

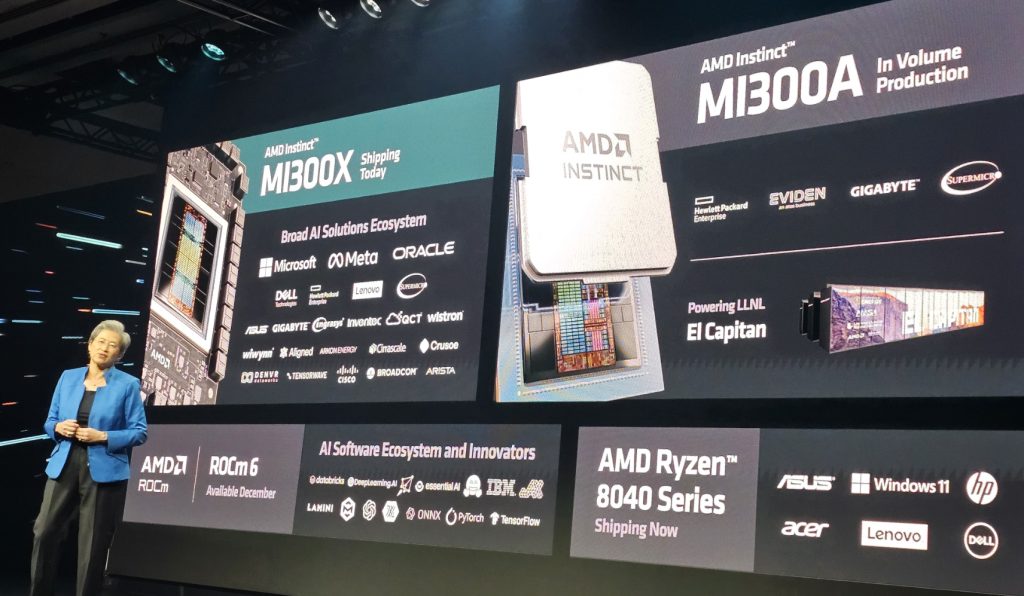

Som nämnts ovans så innebar lanseringen av Ryzen 7040 en mer konkret övergång till AI orienterade processorer. Under eventet så presenterade AMDs CEO Lisa Su den naturliga efterföljaren i form av 8040 serien som redan har gått till produktion. Men Lisa hintade även om modellen som kommer härefter vilken även den är planerad att lanseras under kommande år.

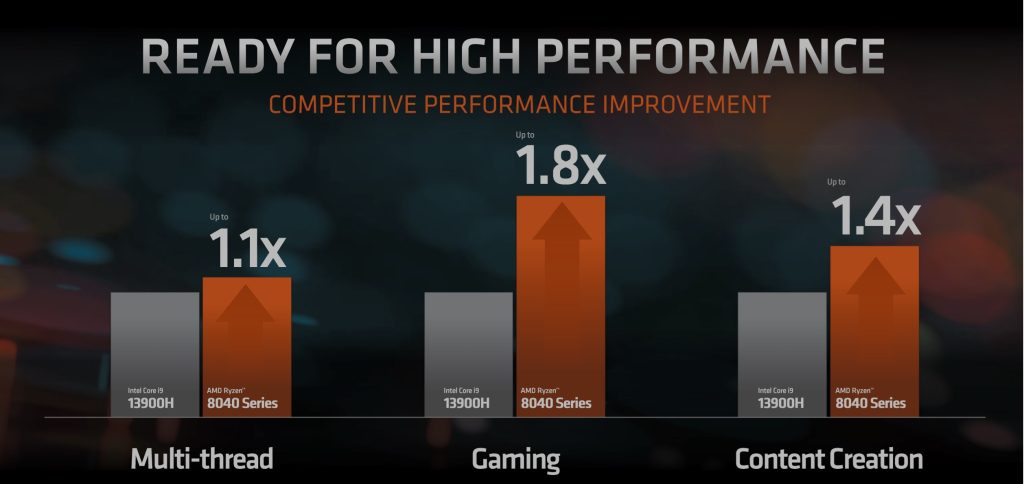

Börjar vi kort med att titta på Ryzen 8040 serien så har dessa modellen en NPU baserad på AMDs XDNA, en processorkärna baserad på AMDs ZEN4 arkitektur samt integrerad GPU baserad på AMDs RDNA3. Detta ger processorn en generell prestanda boost över föregående modell med upp till 40 procent sett till såväl Llama2 som Vision Models.

Men framför allt så innebär processorn ett klart lyft gentemot konkurrerande modeller där exempelvis Intels Core I9-13900H hamnar ganska markant på efterkälken då 8040 serien presterar upp till 80 procent bättre i spel och 40 procent bättre inom olika former av innehållskapande. Det är inte utan att vi ser fram emot Intels kommande, även de AI optimerade modeller, för att se hur dessa förhåller sig mot AMDs motsvarighet.

Initialt så lanseras nio olika SKUs från Ryzen3 med fyra kärnor och åtta trådar till toppmodellen Ryzen 9 med åtta kärnor och sexton trådar. Värt att notera att de två ingångsmodellerna, vilka även utrustats med Radeon 740M grafik, inte kommer med en integrerad NPU del. Men framför allt så erbjuder 8040 serien en ökning av NPU TOPS ( Trillion Operations per Second) från tio till sexton och Total TOPS från 33 till 39 jämfört med föregående serie.

Vi måste såklart även kort nämna nästa generations Ryzen AI som går under kodnamnet Strix Point och som är den första modell att baseras på andra generationens XDNA. Denna kommer att ge en ökning av den generativa AI NPU prestandan med över tre gånger.

DC orienterade AI lösningar

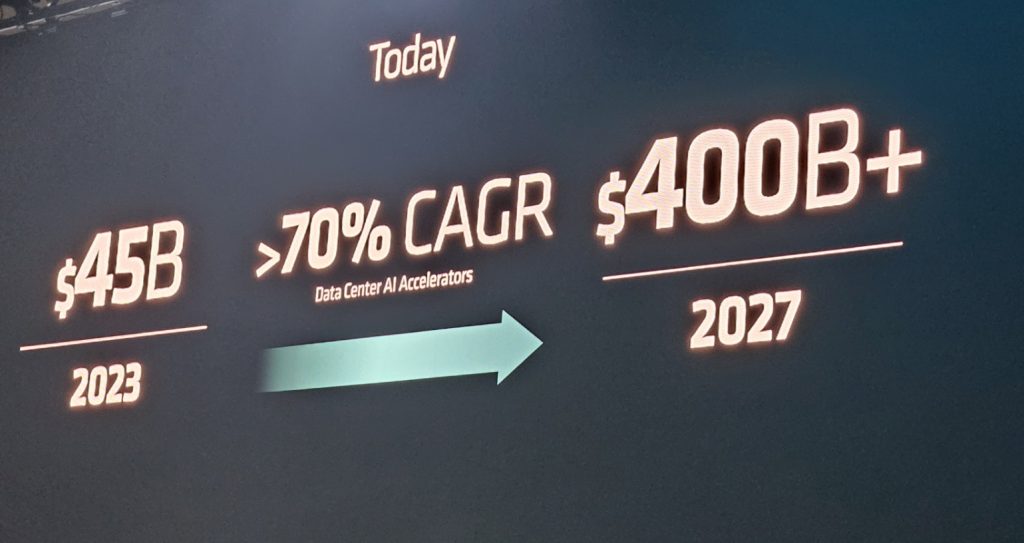

Nästa stora ämne under Keynoten var så klart de datacenter baserade lösningar som presenterades redan under junieventet. Vad som dessutom var extra intressant och som verkligen visar på hur snabbt utvecklingen inom AI går var AMDs uppskattning av områdets tillväxt. För ett halvår sedan gjordes en prognos att marknaden, sett till de ekonomiska möjligheter som ges, skulle växa med 50 procent per år och vid 2027 nå 150 miljarder dollar.

Men under Keynoten så hade Lisa Su redan reviderat denna prognos och nu räknar AMD med en årlig ökning om 70 procent vilken get ger en marknadspotential motsvarade 400 miljarder dollar 2027. Stommen till denna tillväxt ser vi primärt kopplad mot Generativ AI där AMD, med sina Epyc, Instict, Alveo och Pensando enheter, har en komplett portfölj.

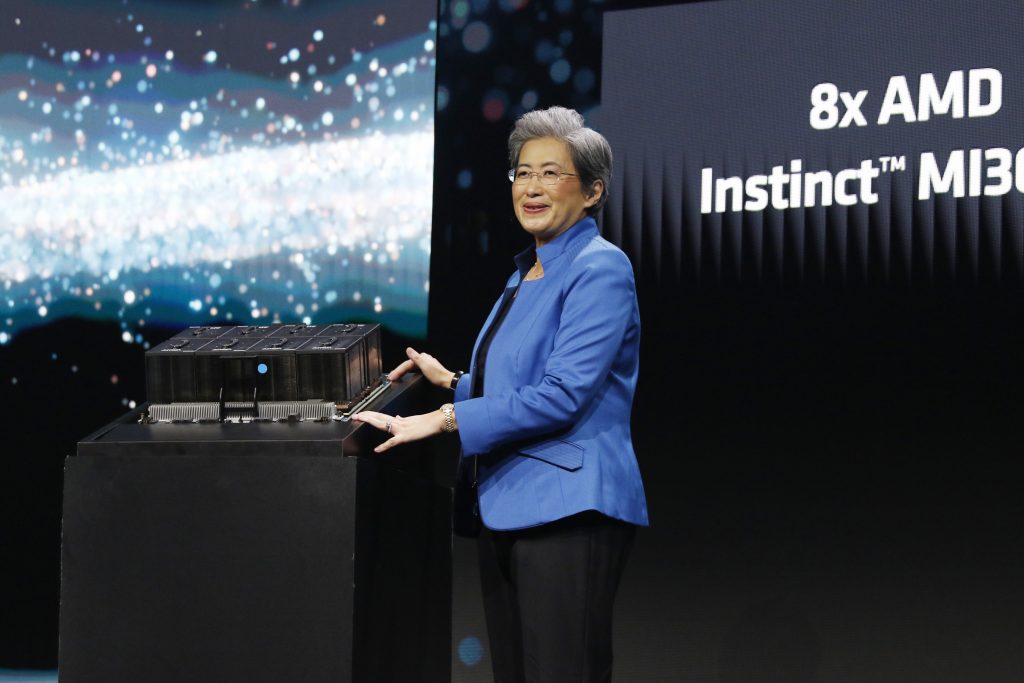

Fokus denna dag låg på datacenter orienterade APU och diskreta GPU lösningarna i MI300 serien med sin unifierade minneshantering och CDNA 3, tredje generationens AI arkitektur. I det för eventet uppsatta demorummet så visades Instinct MI300X, marknadens i skrivandes stund snabbaste AI accellerator, modellens kapacitet upp. Denna enhet baseras på CDNA 3 och kommer med 192 gigabyte HMB3 för en maximal minnesbandbredd på hela 5,3 terabyte per sekund som sedan använder AMDs Infinity Fabric med en bandbredd på 896 gigabyte per sekund.

Enheten bygger på den mest avancerade och komplexa arkitektur som AMD tagit fram där 8 XCD:s med vardera 304 CNDA3 beräkningsenheter, 4 IODs, 8 MHB3 lager, 256 megabyte Infinity cache packas i en 3,5D struktur och en singel enhet. När detta jämförs med Nvidias motsvarighet, H100 SXM, så presterar MI300X i snitt 30 procent bättre prestanda samtidigt som man erbjuder 2,4 gånger högre minneskapacitet.

Att intresset för MI300X varit extremt stor märktes även då i princip samtliga större tillverkare redan under eventet presenterade lösningar som baserades på acceleratorn, mer om dessa nedan.

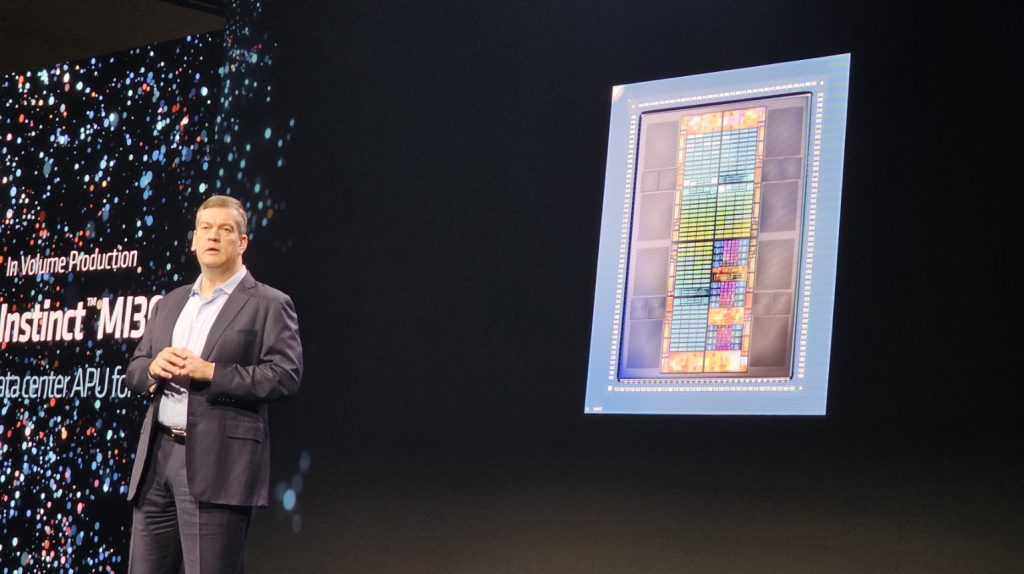

Som komplement till acceleratorn så visades även AMD upp världens första APU accelerator för AI och HPC i form av MI300A. Även denna bygger på CDNA 3 och kommer med 128 gigabyte HMB3. Men då APUn använder fjärde generationens Infinity arkitektur så har det skett en mycket intressant förändring sett till minneshanteringen jämfört med föregående modell. AMD har med MI300A gått från en lösning med separat minne för GPU och CPU del till en lösning där Zen4 kärnorna och CDNA 3 använder en delad HMB3 baserad minnesuppsättning vilket ger en högre prestanda till en lägre effekt.

Även MI300A bygger på samma 3,5D arkitektur som MI300X men här får vi 6 XCD:s med vardera 228 CDNA3 beräkningsenheter. Dessa kompletteras sedan med 3 CCD:s och 24 Zen4 CPU kärnor. När sedan även denna modell kördes mot H100 SXM så fick vi i flera fall en likvärdig prestanda gällande AI prestanda. Men när vi tittade på HPC prestanda så presterade MI300A i snitt 80 procent bättre. Det intressantaste i dessa siffror var att största delen av denna prestandavist gick att koppla direkt mot den delade minneshanteringen och den höga minnesbandbredden.

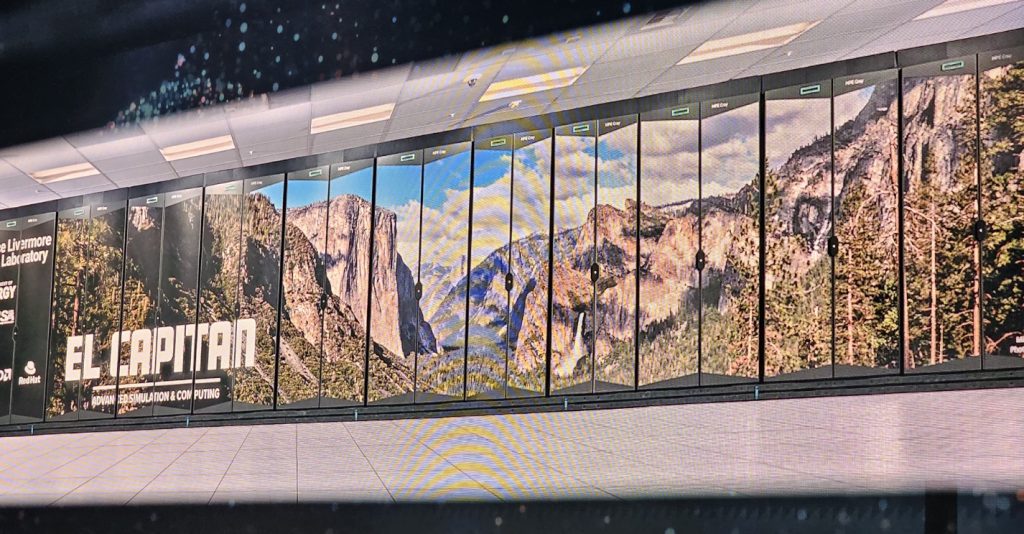

Förutom att flera, normala HPC-, och DC-lösningar baserade på MI300A presenterades under eventet så var det LLNL:s nya superdator El Capitan som ådrog sig mest uppmärksamhet. Denna, när den är i full drift, beräknas vara världens första superdator som passerar två exaflop, och detta med en bas i APUer vilket säger en hel del.

Nu är det inte bara hårdvaran som är ny och optimerats för AI belastningar utan även mjukvarustacken har fått en uppdatering där vi med Vitis AI får en lösning för klienter, integrerade system och olika former av End Pointlösningar, med ZenDNN får en lösning för datacenters CPUer medan ROCm används för datacenters GPUer.

Med senaste generationen ROCm 6 så får kunder nya optimeringsmöjligheter för generativ AI med bland annat prestandaoptimeringar inom LLM där vi ser förbättringar på mellan 1,3 och över 2,6 gånger jämfört med tidigare generation. När vi sedan kombinerar detta med nya MI300X så prestandavinsten enorm och vid en demo som jämförde ROCm5 och MI250 med ROCm6 och MI300X över Llama2 70B gränssnitt så uppnåddes en latensförbättring på 800 procent.

Partnerlösningar

Förutom att Lisa Su under Keynoten frekvent pratade om hur AMD leder utvecklingen inom AI och vi trots att tekniken funnits ett antal år bara är i dessa linda. Att denna AI drivna Era som vi är på väg in i troligen är den största förändring som manligheten upplevt, kanske i kombination med utvecklingen av Internet, så lyfte Lisa även vikten av partnerskap som blir allt viktigare

- AI är framtiden både sett till datorer och världen i helhet och AMD är unikt positionerad att ta och driva ett helhetsperspektiv. Från massiva molninstallationer till företagskluster och AI-aktiverade, intelligenta integrerade enheter och datorer. Vi ser en mycket stark efterfrågan på våra nya Instinct MI300 GPU:er, som är de kraftfullaste prestandaacceleratorerna i världen för generativ AI. Vi jobbar även hårt med våra AI-lösningar för olika former av datacenters från de största molnföretagen till innovativa AI-startups vilka vi jobbar nära med för att accelerera införandet av olika Instinct MI300 lösningar till marknaden. Men trots att vi ligger i täten, eller leder utvecklingen inom AI, så hade vi aldrig kunnat nå hit utan våra partners som via unika och innovativa lösningar på både hård- och mjukvarusidan gör ekosystemet komplett, säger Lisa.

Så vi avrundar denna genomgång med att lyfta fram några av de partners som närvarade under eventet och deras bidrag eller lösningar för att för AI på alla plan framåt.

- Microsoft: Microsoft, som representerade både den mjuka och mer hårda sida berättade om hur man använder AMD Instinct MI300X-acceleratorer för att driva nya Azure ND MI300x v5 Virtual Machine (VM)-serien som är optimerad för AI-arbetsbelastningar. Dessutom så pratade Pavan Davuluri, CVP för Windows och Devices om hur Microsoft och AMD arbetar nära om utvecklingen av Microsoft nya tjänst Co-Pilot och hur de bygger en ny systemarkitektur som kommer att kombinera kraften från GPU, NPU och molnet för framtida AI innovationer.

- Meta: Ajit Mathews, Senior Director Engineering vid Meta AI berättade att företaget lägger till AMD Instinct MI300X-acceleratorer till sina datacenters i kombination med ROCm 6 för att driva AI-kärvade arbetsbelastningar och förklarade även hur ROCm 6-optimeringarna AMD har gjort på Llama 2-modellerna har förbättrat företagets prestanda.

- Oracle: Karan Batta, SVP, Oracle Cloud Infrastructure avslöjade planer på att erbjuda OCI-datorlösningar av barmetall med AMD Instinct MI300X acceleratorer samt planer på att inkludera AMD Instinct MI300X acceleratorer i deras kommande generativa AI-tjänst.

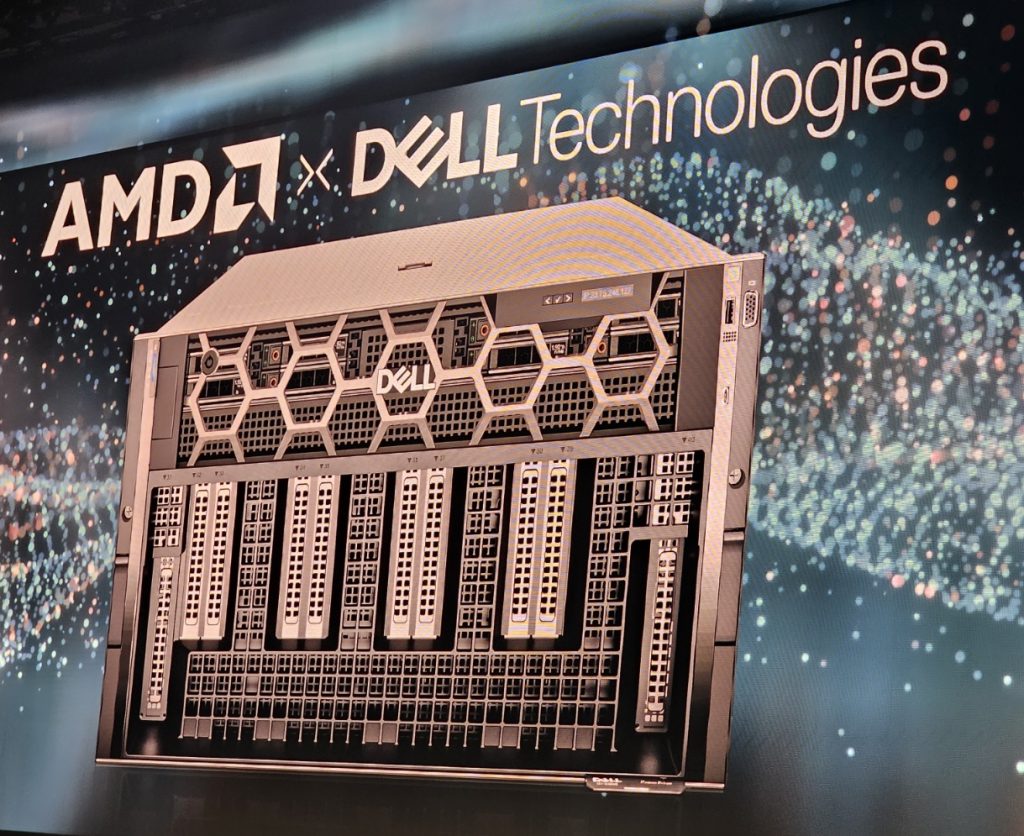

- Dell: Dell meddelade integration av AMD Instinct MI300X-acceleratorer med deras PowerEdge XE9680-serverlösning för att leverera banbrytande prestanda för generativa AI-arbetsbelastningar i ett modulär och skalbart format för kunder.

- Lenovo: Lenovo delade planer på att använda AMD Instinct MI300X-acceleratorer till Lenovo ThinkSystem-plattformen för att leverera AI-lösningar över olika branscher inklusive detaljhandel, tillverkning, finansiella tjänster och hälsovård.

Utöver dessa så visades även lösningar från ett flertal andra partners som: HPE, Supermicro, Asus, Gigabyte, Ingrasys, Inventec, QCT, Wistron och Wiwynn vilka samtliga planerar att erbjuda lösningar som drivs av AMD Instinct MI300-acceleratorer.